Современные приложения часто сталкиваются с необходимостью обработки огромного объема данных. С развитием микросервисной архитектуры обработка сообщений в реальном времени стала ключевой задачей для бизнеса. Но как справляться с этим эффективно? Один из ответов — использование Spring Cloud Stream и Apache Kafka.

Почему Spring Cloud Stream и Kafka?

Spring Cloud Stream предоставляет удобную и мощную абстракцию для создания приложений, обрабатывающих события (event-driven architecture). В сочетании с Kafka — одной из самых популярных систем для передачи потоков данных — вы получаете инструмент, способный выдерживать колоссальные нагрузки.

Kafka позволяет:

• Обрабатывать миллионы сообщений в секунду.

• Сохранять сообщения для повторной обработки.

• Масштабировать приложения горизонтально.

Spring Cloud Stream, в свою очередь, упрощает работу с Kafka: вы получаете декларативное управление конфигурацией, а логика обработки сосредоточена в вашем коде.

Kafka позволяет:

• Обрабатывать миллионы сообщений в секунду.

• Сохранять сообщения для повторной обработки.

• Масштабировать приложения горизонтально.

Spring Cloud Stream, в свою очередь, упрощает работу с Kafka: вы получаете декларативное управление конфигурацией, а логика обработки сосредоточена в вашем коде.

Как это работает?

1. Концепция: каналы и биндинги

В основе Spring Cloud Stream лежит концепция каналов (channels) и биндингов (bindings). Каналы — это логические входы и выходы для обработки данных, которые подключаются к внешним системам вроде Kafka.

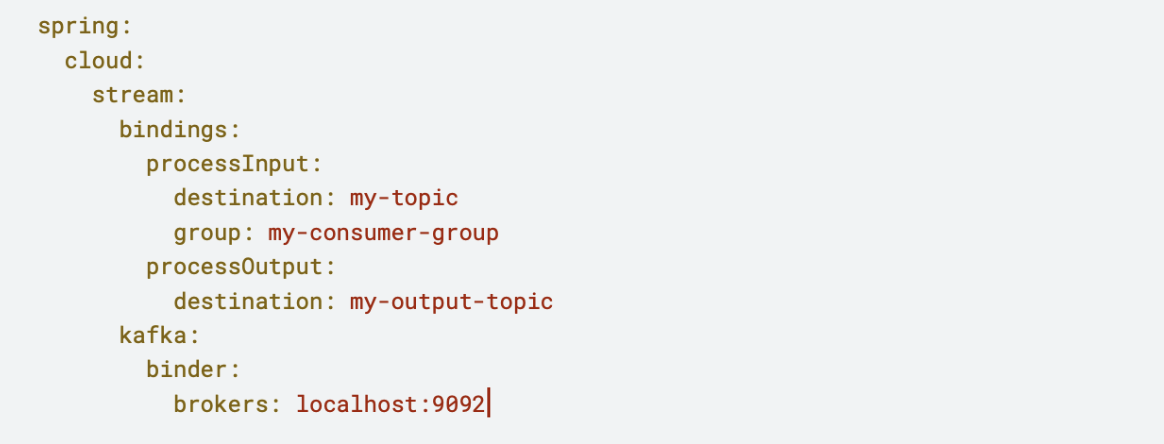

Пример конфигурации:

В основе Spring Cloud Stream лежит концепция каналов (channels) и биндингов (bindings). Каналы — это логические входы и выходы для обработки данных, которые подключаются к внешним системам вроде Kafka.

Пример конфигурации:

Здесь:

• processInput и processOutput — это биндинги.

• my-topic и my-output-topic — это топики Kafka, с которыми приложение взаимодействует.

• processInput и processOutput — это биндинги.

• my-topic и my-output-topic — это топики Kafka, с которыми приложение взаимодействует.

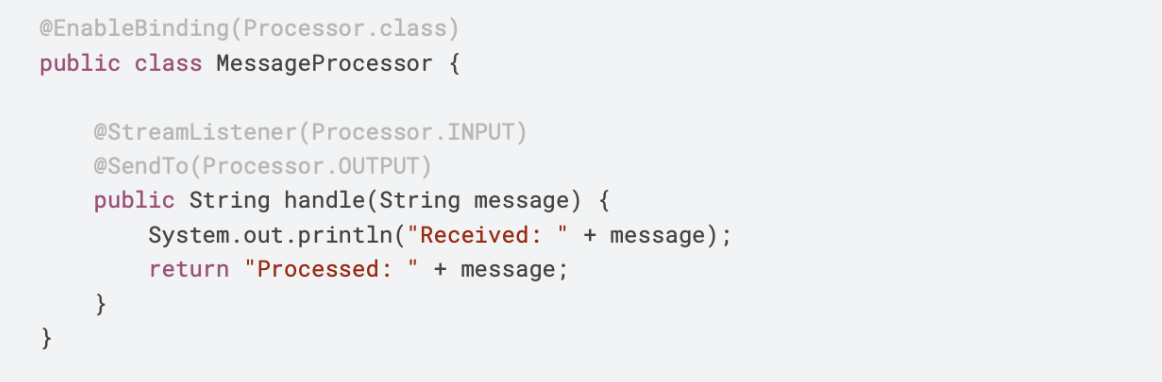

2. Создание обработчика сообщений

После настройки достаточно определить обработчик:

После настройки достаточно определить обработчик:

Здесь сообщение из входного топика читается, обрабатывается и отправляется в выходной топик.

Преимущества подхода

1. Масштабируемость

Kafka поддерживает разделение данных на партиции, что позволяет распределять нагрузку между несколькими потребителями.

2. Устойчивость к сбоям

Сообщения в Kafka сохраняются, пока они не будут прочитаны и подтверждены, что снижает риск потери данных.

3. Гибкость конфигурации

Spring Cloud Stream поддерживает множество провайдеров (RabbitMQ, Kafka, Redis), а конфигурации легко менять без изменения кода.

Kafka поддерживает разделение данных на партиции, что позволяет распределять нагрузку между несколькими потребителями.

2. Устойчивость к сбоям

Сообщения в Kafka сохраняются, пока они не будут прочитаны и подтверждены, что снижает риск потери данных.

3. Гибкость конфигурации

Spring Cloud Stream поддерживает множество провайдеров (RabbitMQ, Kafka, Redis), а конфигурации легко менять без изменения кода.

Реальный пример: как обрабатывать массы сообщений

Представьте интернет-магазин, обрабатывающий заказы. Каждый заказ — это сообщение, которое нужно:

• Проверить на корректность.

• Сохранить в базу.

• Уведомить отдел логистики.

С Spring Cloud Stream и Kafka обработка выглядит так:

1. Заказы поступают в топик orders.

2. Приложение обрабатывает каждое сообщение, распределяя задачи между несколькими consumer-ами с разными consumer group-ами. Например, один consumer формирует заказ, второй создаёт документ о товаре для пользователя, а третий записывает данные в статистику. При этом Kafka позволяет повторно прочитать сообщение из топика, если возникла необходимость.

3. Логистический сервис получает уведомления из топика shipping. Используя аннотацию @SendTo, результат обработки можно перенаправить в другие топики, например, для формирования чека на оплату, создания сопроводительных документов или интеграции с внешними системами.

• Проверить на корректность.

• Сохранить в базу.

• Уведомить отдел логистики.

С Spring Cloud Stream и Kafka обработка выглядит так:

1. Заказы поступают в топик orders.

2. Приложение обрабатывает каждое сообщение, распределяя задачи между несколькими consumer-ами с разными consumer group-ами. Например, один consumer формирует заказ, второй создаёт документ о товаре для пользователя, а третий записывает данные в статистику. При этом Kafka позволяет повторно прочитать сообщение из топика, если возникла необходимость.

3. Логистический сервис получает уведомления из топика shipping. Используя аннотацию @SendTo, результат обработки можно перенаправить в другие топики, например, для формирования чека на оплату, создания сопроводительных документов или интеграции с внешними системами.

Как начать?

1. Установите Kafka локально или в облаке (например, Confluent Cloud).

2. Подключите Spring Boot к Kafka через Spring Cloud Stream.

3. Настройте биндинги, создайте обработчики сообщений.

2. Подключите Spring Boot к Kafka через Spring Cloud Stream.

3. Настройте биндинги, создайте обработчики сообщений.

Вывод

Spring Cloud Stream в связке с Kafka — это мощный инструмент для обработки больших объемов сообщений. Он помогает не только справляться с нагрузкой, но и создавать отказоустойчивые, масштабируемые системы. Вопрос лишь в том, готовы ли вы использовать эти технологии, чтобы вывести свои приложения на новый уровень?